En un mundo cada vez más interconectado, el aprendizaje de idiomas se ha vuelto esencial para la educación, los negocios y el intercambio cultural. Sin embargo, medir con precisión la competencia de los estudiantes en un idioma es un desafío complejo. Una de las metodologías más valiosas para evaluar la competencia lingüística es la imitación elicida (EI, por sus siglas en inglés), que consiste en que los estudiantes escuchen oraciones y las repitan con la mayor precisión posible.

La EI revela más que la simple capacidad de memoria y mimetismo. Cuando las oraciones superan la capacidad de memoria de trabajo —que normalmente se sitúa entre ocho y diez sílabas—, la repetición exitosa exige que los estudiantes procesen y reconstruyan rápidamente el lenguaje utilizando su conocimiento internalizado de patrones y estructuras. Por lo tanto, la EI puede ofrecer una visión clara de la verdadera competencia lingüística de un individuo.

A pesar de que esta técnica ha sido perfeccionada a lo largo de las décadas, su adopción generalizada ha estado limitada por un reto práctico significativo: la necesidad de evaluadores humanos capacitados que escuchen y califiquen cada respuesta. Este proceso, que consume mucho tiempo, dificulta las evaluaciones a gran escala, a pesar de la efectividad comprobada de la EI.

Ante este contexto, un equipo de investigación liderado por el profesor asociado Michael McGuire de la Universidad Doshisha en Japón y la doctora Jenifer Larson-Hall de la Universidad de Kitakyushu ha desarrollado un enfoque automatizado para la evaluación de la EI. Su reciente trabajo, publicado en Research Methods in Applied Linguistics, muestra cómo la inteligencia artificial puede revolucionar este proceso.

Automatización de la Evaluación Lingüística

Los investigadores propusieron una solución en dos partes para automatizar las pruebas de EI: primero, utilizando Whisper de OpenAI, un sistema de reconocimiento automático de voz (ASR), para transcribir las respuestas orales de los estudiantes a texto; y segundo, aplicando una métrica computacional denominada «Tasa de Error de Palabras (WER)» para evaluar cómo se ajustaban estas respuestas a los enunciados originales.

Se eligió Whisper ASR debido a su alta precisión con el habla de no nativos y su tolerancia al ruido de fondo, mientras que WER ofrece una forma precisa de medir las desviaciones respecto a las oraciones objetivo, identificando sustituciones, inserciones y eliminaciones a nivel de palabra. El equipo teorizó que, juntos, estos métodos podrían reemplazar a los evaluadores humanos sin comprometer la calidad de la evaluación.

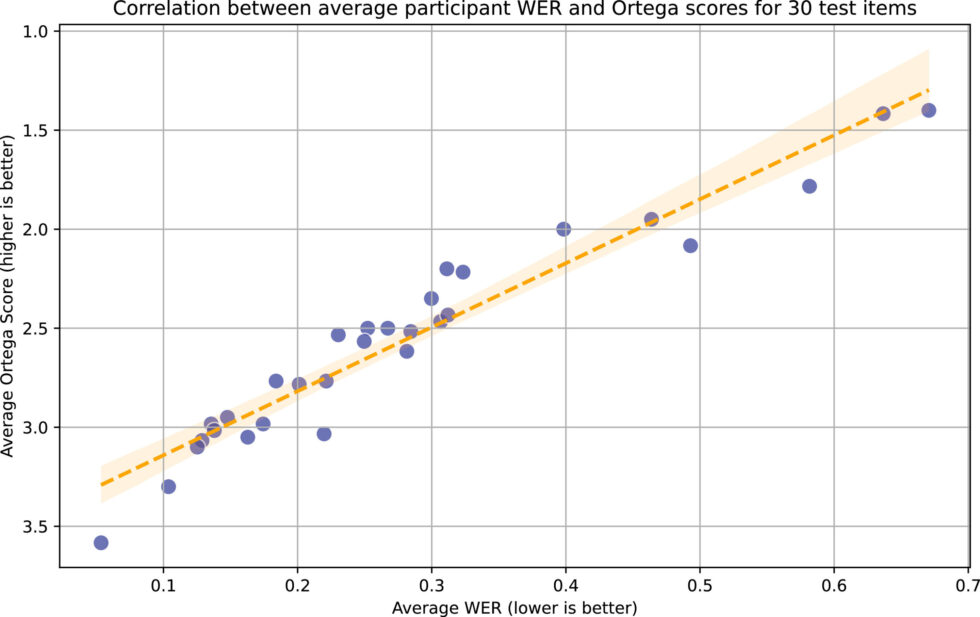

Para probar este enfoque, reclutaron a 30 estudiantes universitarios japoneses con diferentes niveles de competencia en inglés, quienes completaron una prueba de EI de 30 ítems. Las 900 muestras de habla resultantes fueron transcritas tanto por evaluadores humanos como por el sistema Whisper ASR. Sorprendentemente, encontraron que las transcripciones de Whisper coincidían con las de los evaluadores humanos, demostrando una precisión excepcional, incluso en condiciones de prueba no ideales que incluían ruido de fondo, lo que subraya la robustez del sistema en entornos educativos reales.

Lo más importante es que la puntuación automatizada se alineó extremadamente bien con los métodos de evaluación tradicionales, mostrando una correlación casi perfecta. Según McGuire, «Nuestro estudio demuestra la viabilidad y fiabilidad de las pruebas de habla completamente automatizadas para los estudiantes de inglés, las cuales pueden llevarse a cabo a gran escala y a bajo costo, lo que hace que la evaluación de la competencia oral sea mucho más accesible y fiable para su uso generalizado.»

Las implicaciones van más allá de simplemente ahorrar tiempo y recursos a los docentes. La evaluación automatizada podría permitir una evaluación más frecuente de las habilidades orales de los estudiantes, proporcionando la retroalimentación oportuna crucial para el desarrollo del lenguaje. También facilitaría estudios a gran escala que anteriormente eran inviables debido a las exigencias de la puntuación manual.

El equipo de investigación ya está trabajando para hacer realidad estos objetivos. McGuire afirma que «actualmente estamos desarrollando una plataforma de prueba de EI basada en la web, que planeamos automatizar completamente utilizando Whisper ASR y WER para que las pruebas puedan realizarse en un teléfono inteligente y la puntuación pueda hacerse en línea en tiempo real. Esperamos hacer esta plataforma completamente automatizada disponible para otros investigadores y educadores en un futuro cercano.»

De cara al futuro, los investigadores también planean ampliar su enfoque para desarrollar múltiples formas de pruebas estandarizadas con niveles de dificultad equivalentes, lo que permitirá un seguimiento más fiable del desarrollo del lenguaje a lo largo del tiempo. También prevén la creación de pruebas específicas del currículo centradas en vocabulario y características gramaticales particulares, e incluso pruebas adaptativas que podrían identificar la competencia oral de manera más eficiente que los métodos actuales.

A medida que la inteligencia artificial continúa avanzando, esta investigación representa un paso significativo hacia la posibilidad de hacer que la evaluación lingüística fiable sea más accesible y escalable.