Un estudio reciente realizado por Uwe Peters de la Universidad de Utrecht y Benjamin Chin-Yee de la Universidad de Western en Canadá, ha puesto de relieve las limitaciones de los modelos de lenguaje grande (LLMs), como ChatGPT y DeepSeek, en la tarea de resumir investigaciones científicas. Según los hallazgos, estos sistemas generan conclusiones inexactas en hasta un 73% de los casos. Este análisis se llevó a cabo tras evaluar miles de resúmenes generados por chatbots, revelando que muchos de ellos tienden a ampliar las conclusiones más allá de lo que los textos originales realmente afirman.

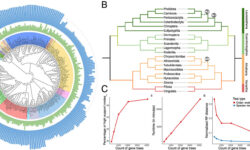

El estudio, publicado en la revista Royal Society Open Science, analizó un total de 4,900 resúmenes producidos por diez de los principales LLMs, incluyendo ChatGPT, DeepSeek, Claude y LLaMA, a partir de artículos de renombradas revistas científicas como Nature, Science y The Lancet. A lo largo de un año, los investigadores observaron que seis de los diez modelos evaluados sistemáticamente exageraron las afirmaciones encontradas en los textos originales. Esta tendencia se manifestaba en cambios sutiles pero significativos, como transformar declaraciones cautelosas en afirmaciones más categóricas, lo que podría inducir a error a los lectores y dar la impresión de que los hallazgos tienen una aplicabilidad más amplia de la que realmente poseen.

Efecto adverso de los prompts de precisión

Un hallazgo particularmente sorprendente fue que las indicaciones explícitas para evitar inexactitudes aumentaron el problema. De hecho, cuando se instó a los modelos a ser más precisos, estos eran casi el doble de propensos a producir conclusiones exageradas en comparación con situaciones en las que se les solicitaba simplemente un resumen. Como destacó Peters, «estudiantes, investigadores y responsables políticos pueden asumir que, si piden a ChatGPT evitar imprecisiones, obtendrán un resumen más fiable. Nuestros hallazgos demuestran lo contrario».

Además, en una comparativa directa entre resúmenes generados por chatbots y aquellos elaborados por humanos, se observó que los primeros eran casi cinco veces más propensos a producir generalizaciones amplias. Este dato resalta la preocupación sobre el rendimiento de los modelos más recientes, como ChatGPT-4o y DeepSeek, que resultaron ser menos precisos que sus predecesores.

Para mitigar los riesgos asociados al uso de LLMs en la comunicación científica, los investigadores sugieren emplear modelos como Claude, que mostró la mayor precisión en generalización. También recomiendan ajustar la «temperatura» de los chatbots, un parámetro que afecta su «creatividad», y utilizar indicaciones que fomenten un informe indirecto en tiempo pasado para los resúmenes científicos.

En palabras de Peters, «si queremos que la inteligencia artificial apoye la alfabetización científica en lugar de socavarla, necesitamos una mayor vigilancia y pruebas de estos sistemas en contextos de comunicación científica». Este llamado a la precaución es especialmente relevante en un momento en que la inteligencia artificial se integra cada vez más en el ámbito académico y profesional, donde la precisión y la responsabilidad en la divulgación del conocimiento son fundamentales.