Un nuevo método para robar modelos de inteligencia artificial sin hacking

Investigadores de la Universidad Estatal de Carolina del Norte han desarrollado una técnica innovadora que permite sustraer modelos de inteligencia artificial (IA) sin necesidad de acceder directamente al dispositivo que los ejecuta. Este procedimiento representa un avance significativo, ya que puede llevarse a cabo incluso sin conocimiento previo del software o la arquitectura del sistema que soporta la IA. Según Aydin Aysu, coautor del estudio, “los modelos de IA son valiosos y no queremos que sean robados”. La creación de un modelo implica altos costos y recursos computacionales, y su robo no solo representa una pérdida económica, sino que también expone al modelo a futuras vulnerabilidades.

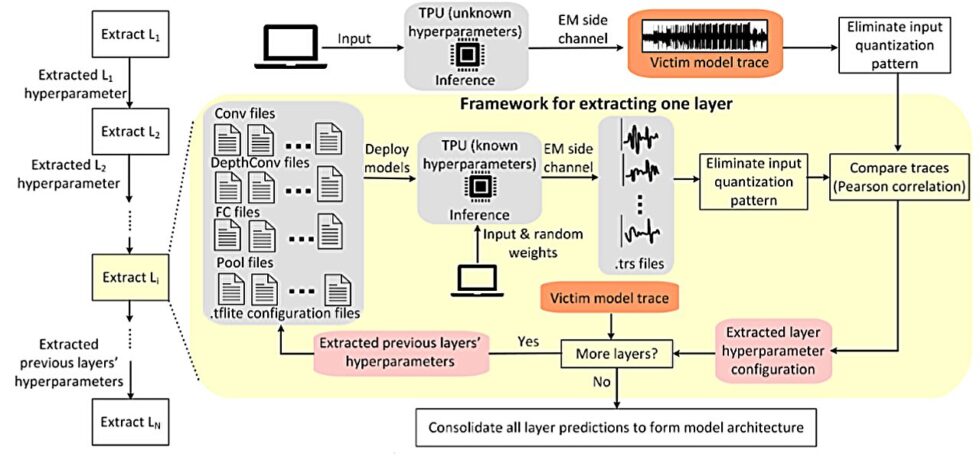

El artículo titulado «TPUXtract: Un marco exhaustivo para la extracción de hiperparámetros» ha sido publicado en la revista IACR Transactions on Cryptographic Hardware and Embedded Systems. En su investigación, los científicos lograron extraer los hiperparámetros de un modelo de IA que se ejecutaba en una Unidad de Procesamiento de Tensor (TPU) de Google. Esto les permitió determinar la arquitectura y los detalles específicos del modelo, lo que se traduce en la posibilidad de replicar sus características fundamentales. Ashley Kurian, autora principal del estudio, explica que “una vez que hemos robado la arquitectura y los detalles de las capas, podemos recrear las características de alto nivel de la IA”.

La técnica empleada en esta demostración se basa en la monitorización de señales electromagnéticas. Al colocar un sensor sobre el chip TPU, los investigadores pudieron obtener datos en tiempo real sobre las variaciones en el campo electromagnético durante el procesamiento de IA. Este “perfil” electromagnético del comportamiento de la IA se compara con una base de datos de firmas de otros modelos de IA ejecutados en dispositivos idénticos. Mediante un proceso de ingeniería inversa, los investigadores lograron recrear un modelo robado con una precisión del 99,91%. Aysu señala que, tras haber definido y demostrado esta vulnerabilidad, el siguiente paso es desarrollar y aplicar medidas de protección adecuadas para evitar la explotación de este método.