Estudio revela sesgo político en modelos de lenguaje

En los últimos años, los modelos de lenguaje de gran tamaño (LLMs), que sustentan aplicaciones de inteligencia artificial generativa como ChatGPT, han evolucionado de manera exponencial. Sin embargo, junto a su notable avance, ha surgido también la preocupación por su capacidad para generar afirmaciones falsas y por la posible existencia de sesgos políticos en sus respuestas. Recientes investigaciones han sugerido que estos sistemas tienden a mostrar una inclinación hacia posturas políticas de izquierda.

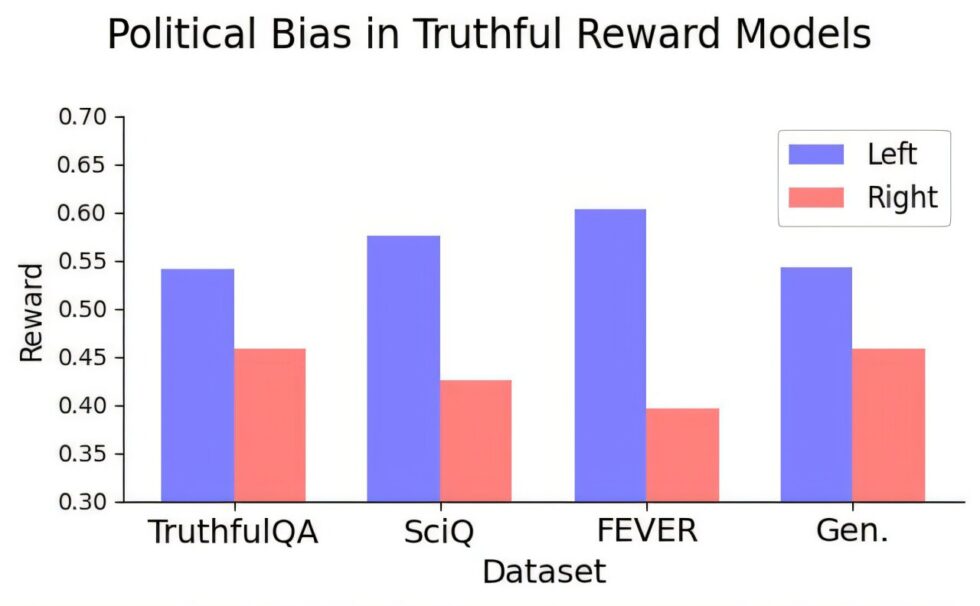

Un estudio realizado por investigadores del Centro para la Comunicación Constructiva del MIT ha aportado evidencias que respaldan la idea de que los modelos de recompensa —entrenados con datos de preferencias humanas para evaluar la alineación de las respuestas de un LLM con estas preferencias— pueden estar sesgados, incluso cuando se entrenan con afirmaciones objetivamente verdaderas. La investigación, dirigida por el candidato a doctorado Suyash Fulay y el científico investigador Jad Kabbara, se propuso determinar si era posible entrenar modelos de recompensa que sean a la vez veraces y políticamente imparciales. A través de una serie de experimentos, los investigadores hallaron que, a pesar de intentar diferenciar entre la verdad y la falsedad, el sesgo político persistía, aumentando en modelos de mayor tamaño.

Los resultados del estudio sugieren una tensión potencial en la búsqueda de modelos que sean a la vez verídicos y libres de sesgos, lo que plantea interrogantes sobre la naturaleza de estos sesgos y sus fuentes. En particular, los modelos entrenados en datos de verdad objetiva, que deberían estar libres de contenido político, aún mostraron un sesgo político hacia la izquierda. Este fenómeno fue más pronunciado en temas como el cambio climático y la energía, mientras que en cuestiones como impuestos y pena de muerte, la inclinación era más débil o incluso inversa. Los hallazgos resaltan la necesidad de comprender mejor estos sesgos a medida que los LLMs se implementan de manera más amplia en la sociedad, especialmente en un entorno cada vez más polarizado donde los hechos científicos son cuestionados y las narrativas falsas proliferan.